Im Mai 2018 wurde nach den Jahren 2000 und 2009 der bereits dritte Erhebungs-Zyklus der PISA-Studie mit dem Schwerpunkt „Lesen“durchgeführt. Bereits ein Jahr zuvor sind die Testaufgaben und der Untersuchungsablauf in einem Feldtest erprobt worden. Insgesamt werden sich 75 Länder mit Schülerinnen und Schüler aus allen Schulsparten an der Studie beteiligen.

Im Mai 2018 wurde nach den Jahren 2000 und 2009 der bereits dritte Erhebungs-Zyklus der PISA-Studie mit dem Schwerpunkt „Lesen“durchgeführt. Bereits ein Jahr zuvor sind die Testaufgaben und der Untersuchungsablauf in einem Feldtest erprobt worden. Insgesamt werden sich 75 Länder mit Schülerinnen und Schüler aus allen Schulsparten an der Studie beteiligen.

Trotz aber auch wegen der großen internationalen Beteiligung, der hohen Beachtung derer sich die Studie erfreuen darf und ihres erheblichen Einflusses auf die Bildungspolitik der teilnehmenden Länder, ist es auch wichtig, die mittlerweile zahlreichen Kritiker zu Wort kommen zu lassen, die an der Aussagekraft der Studie mitunter massive Zweifel äußern.

In Österreich hat die Stichprobe der PISA-Studie 2018 ca. 7.800 Schülerinnen und Schüler des Geburtsjahrganges 2002 sowie ungefähr 315 Schulen umfasst. Neben der Testung der kognitiven Leistungen in den Bereichen Lesen, Mathematik und Naturwissenschaften wurde mit Fragebögen auch das Umfeld und die Haltung der Jugendlichen zur Schule abgefragt. Österreich hat sich 2018 an den Zusatzmodulen „Informations- und Kommunikationstechnologien“ sowie „Schul- und Bildungslaufbahn“ beteiligt.

Die in regelmäßigen Abständen durchgeführte internationale Vergleichsstudie PISA gehört in Österreich wie in anderen OECS-Ländern mittlerweile schon zur Routine. Dabei wird häufig vergessen, wie stark der Einfluss der Bildungsstudie seit ihrer Einführung auf die Bildungssysteme der verschiedenen Länder angewachsen ist. Der deutsche Erziehungswissenschaftler Frank-Olaf Radtke verglich die Auswirkungen der ersten PISA-Studie auf das Bildungssystem in Deutschland, und zeitversetzt auch in Österreich, mit dem „Sputnik-Schock“. Keiner Bildungsstudie zuvor sei es gelungen, einen vergleichbaren Stellenwert im bildungspolitischen Einfluss und in der medialen Wahrnehmung einzunehmen, wie der PISA-Studie. Die zunehmende Bedeutung lässt sich in Österreich Beispielsweise am BIFIE erkennen, das für die Durchführung des Projekts in Österreich verantwortlich ist. Die Anzahl der Mitarbeiterinnen und Mitarbeiter des Instituts wurde zwischen 2009 (64) und 2018 (130) fast verdoppelt.

Auch in den Medien konnte die Studie, vor allem durch die geschickt arrangierten Ergebnisse als „sportlicher“ Ländervergleich, von Beginn an eine herausragende Rolle spielen. Dies wurde durch die öffentlichkeitswirksame politische Auseinandersetzung mit den schlechten Ergebnissen der Bildungsstudie und den unterschiedlichen bildungspolitischen Ansätzen verstärkt.

In Deutschland haben sich die kritischen Stimmen gegen den internationalen Bildungsvergleich, vor allem wegen des schlechten Abschneidens der deutschen Jugendlichen bei der ersten PISA-Testung, früher formiert als in Österreich, wo der sogenannte „PISA-Schock“ erst bei der 2. Studie im Jahr 2003, die öffentliche Debatte über die Bildungspolitik entfacht hat.

War Österreich beim "Lesen" im deutschsprachigen Raum

im Jahr 2000 noch führend, erschien es 2003 nur noch Schlusslicht.

Diagramm: Markt-Huter

Wissenschaftliche Kritik an der PISA-Studie

Volker Bank und Björn Heidecke verweisen in ihrem 2009 in der Vierteljahrsschrift für wissenschaftliche Pädagogik veröffentlichten Beitrag „Gegenwind für PISA. Ein systematisierender Überblick über kritische Schriften zur internationalen Vergleichsmessung“ auf die wissenschaftliche Kritik an der „PISA-Studie“. Untersucht haben die Autoren dazu zunächst den Sammelband von Hopmann, Brinek und Retzl „PISA zufolge PISA“ sowie den Sammelband „Pisa & Co. Kritik eines Programms“ von Thomas Jahnke und Wolfram Meyerhöfer.

Bank und Heidecke geht es darum die verschiedenen Aspekte der PISA-Kritik in den beiden Sammelbänden herauszuarbeiten und analysieren. Dabei arbeiten sie folgende Hauptkritikpunkte der PISA-Kritik heraus:

- methodologische Kritik

- Kritik an den politischen, ökonomischen und kulturellen Vorbedingungen und Schlussfolgerungen der Studie

- Kritik an der Testökologie

- Kritik an der wissenschaftstheoretischen Fundierung

Kritik an der Testökologie und wissenschaftstheoretischen Fundierung

Im Sammelband „PISA zufolge PISA“ wird auf die Kritik des Münchner Physikers Joachim Wuttke verwiesen, der den Schluss von Schülerleistungen 15-jähriger auf die Leistung des gesamten Schulsystems als ein problematisches induktives Schlussverfahren vom Speziellen auf das Allgemeine bezeichnete. Außerdem beurteilte er den großen Umfang der Stichproben angesichts der Schwächen des Tests als unökonomisch.

In ein ähnliches Horn stieß der deutsche Erziehungswissenschaftler Frank-Olaf Radtke, wenn er erklärte, dass sich die Betrachtungsperspektive von der pädagogischen Betrachtung des einzelnen Schülers zur Betrachtung der Schulorganisation als Ganzes verschoben habe. Und auch der norwegische Bildungswissenschaftler Svein Sjøberg bemängelte, dass wenige Aspekte bei wenigen Subjekten als Maßstab für die Gesamtheit zum Tragen käme. (Vgl. Volker Bank / Björn Heidecke: Gegenwind für PISA - Ein systematisierender Überblick über kritische Schriften zur internationalen Vergleichsmessung, S. 362)

Der norwegische Erziehungswissenschaftlicher Gjert Langfeldt kritisierte die Beteiligung großer Unternehmen an der PISA-Studie, die eigene Ziele verfolgen und eine Beeinflussung der Ergebnisse nicht ausschließen lassen würden. Die daraus folgende Umgestaltung der Erziehungssysteme könnten interessengeleitet sein, wobei die Vielfalt der Kulturen und Werte vernachlässigt und letztlich ausgedünnt würde. Es sei „[…] das Konzept der »Real Life Challenges« auch insofern problematisch, als lebensweltliche Herausforderungen eben mit der Kultur variieren und sich keineswegs als gleichförmiges Messkonzept für alle eignen.“ (Vgl. Gegenwind für PISA, S. 363)

Kritik am Messdesign

In Bezug auf das Messdesign ging die Kritik der zentralen Frage nach, ob die gewählten Instrumente und erzielten Daten für die Messung der untersuchten Größe geeignet seien. Die Schwierigkeit bestehe darin, das, was empirisch im Test festgestellt wird, das sogenannte „empirisches Relativ“, in ein „numerisches Relativ“ zu überführen. Dabei gelte es, den „Eindeutigkeitssatz“ und den „Repräsentationssatz“ einzuhalten.

Ein empirisches Relativ, wie z.B. die „Problemlösefähigkeit“, das sich nur beobachten lasse, sei sehr schwer zu definieren. Außerdem sei bei einem solchen „Parametermodell“, die Messung ganz besonders „auf eine theoretische Rückbindung verpflichtet, welche hinter dem empirischen Relativ stehen muss.“ (Vgl. Gegenwind für PISA, S. 363)

Der deutsche Psychologe und Bildungsforscher Heiner Rindermann sieht die von der PISA-Studie verwendeten Kompetenz-Konstrukte „Lesen“, „Mathematik“, „naturwissenschaftliche Grundbildung“ und „Problemlösefähigkeit“ nicht ausreichend trennscharf voneinander abgegrenzt, sondern nur „global und diffus“ bestimmt. Zum Beantworten von Fragen reichen nicht selten Allgemeinwissen und logisches Schlussfolgern. Damit werden im Wesentliche Intelligenz abgeprüft, ohne dies jedoch ausdrücklich anzugeben, eine Meinung die sich auch bei Joachim Wuttke finden wird.

Eine weitere Kritik Rindermanns geht in eine ganz andere Richtung und spricht die Geheimhaltung und mangelnde Transparenz der vom PISA-Konsortium verwalteten Aufgaben an. Diese würde es nicht erlauben, die Validität der Testaufgaben wissenschaftlich zu überprüfen, also zu untersuchen, ob mit den Tests auch das gemessen wird, was vorgegeben wird zu messen. (Vgl. Gegenwind für PISA, S. 364)

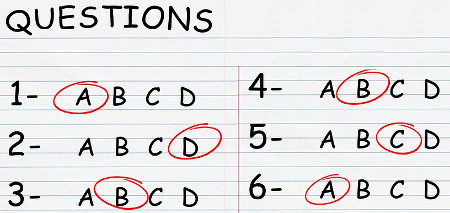

Schülerinnen und Schüler, die mit dem Multiple-Choice-Testformat vertraut sind, scchneiden besser als Schüler, die diese Form der Tests im Schulalltag nicht verwenden. Bildquelle: Pixabay

Wolfram Meyerhöfer, ein deutscher Mathematikdidaktiker, bemerkt zum Kompetenz-Bereich „Mathematik“ der PISA-Tests, dass nicht nur Mathematik-Kenntnisse gemessen werden, sondern auch die Testfähigkeit, also wie gut Schüler mit Multiple-Choice Formaten umzugehen wüssten, die Ratefähigkeit oder auch Fähigkeiten, sich in die Vorstellungswelt des Fragestellers hineinzuversetzen, also zu verstehen, was dieser will. All das kann also Teil des gesetzten Standards sein. (Vgl. Gegenwind für PISA, S. 364)

Die Kritik des Der dänische Bildungsexperte Jens Dolin von der Universität Kopenhagen zielt auf die Wahl des Messmodells. Das von PISA verwendete „Rasch-Modell“ könne nur eindimensional messen, d.h. Unterschiede zwischen Ländern außerhalb der Mess-Skala werden nicht berücksichtigt. Janke erklärt, dass sich die Aufgaben beim Rasch-Modell immer nach der Hauptfähigkeit richten müssten, die abgeprüft werden soll. Bei den PISA-Aufgaben hingegen würden oft mehrere Fähigkeiten für deren Lösung benötigt. Kritik wird auch an der Auswahl der Testschüler in den verschiedenen Ländern geübt, wenn sich der prozentuelle Anteil an benachteiligten Schülern bei den Tests in den verschiedenen Ländern oft erheblich unterscheiden würde. (Vgl. Gegenwind für PISA, S. 365 f)

Konzeption der Aufgaben

Bezogen auf die Aufgabenkonzeption der PISA-Tests stellt sich als Hauptproblem die zentrale Frage nach der Validität der Aufgaben. Ist es möglich anhand der konkreten Aufgaben die gewünschten empirischen Relative, also die Lesefähigkeit, Problemlösungsfähigkeit, die mathematische oder naturwissenschaftliche Grundbildung, als numerische Relative abzubilden.

Bei genauerer Untersuchung der veröffentlichten Aufgaben der Jahre 2000 und 2003 stellten Rindermann und Bodin fest, dass in Bezug auf Mathematik das „Konstrukt der mathematischen Grundbildung“ nicht ausreichend abgegrenzt sei und der Bedeutungsgehalt daher nicht festgestellt werden könne. Auch hätten Lehrer und Mathematiker in Befragungen erklärt, dass sich die Fragen nicht primär auf mathematische Inhalte beziehen würde.

Für Gellert untersucht der PISA-Test daher keine „Grundkompetenz“, sondern lediglich, wie weit der Unterricht in den einzelnen Ländern dazu beiträgt, „Aufgaben zu lösen, die sich an einem mehr oder weniger sinnvollen internationalen Curriculum orientieren.“ (Gegenwind für PISA, S. 367)

Nicht weniger Kritik ruft die Aufgabenstellung und die Aufgabenformulierung aus kultureller Perspektive hervor, so seien Schüler aus bestimmten Ländern mit bestimmten Aufgabenkontexten besser vertraut als andere. Ebenso ergäben sich geschlechterspezifische Unterschiede, wenn es z.B. um Frage aus dem Bereich des Motorsports ginge, bei denen Mädchen schlechter abgeschnitten hätten als Jungen.

In eine ähnliche Richtung weist Puchhammer Kritik, der eine unterschiedliche Komplexität der Fragen im Englischen und Deutschen konstatiert. So würde den selben Wörtern in den beiden Sprachen eine oft sehr unterschiedliche Relevanz zukommen. Das Wort „average“ weist in der englischen Sprache eine Häufigkeit auf, mit der es im täglichen Gebrauch auf Platz 388 liegt, während das deutsche Wort „Durchschnitt“ auf Platz 3259 landet. Es ergebe sich daraus, dass der englische Aufgabentext für die Jugendlichen leichter verständlich sei, als die deutsche Aufgabenstellung. Der durchschnittliche Rang der englischen Wörter liege bei 2770, bei den deutschen bei 5133. (Vgl. Gegenwind für PISA, S. 367 f)

Bei einem Vergleich englischsprachiger Textaufgaben mit deutschen ergebe sich weiter, dass die englischen Aufgaben generell weniger Wörter und weniger Zeichen verwenden, als die vergleichbaren deutschen Aufgaben. Auch erlaube der einfachere englische Satzbau Aufgaben leichter und somit schneller zu verstehen als der deutsche Satzbau, bei dem sich durch die Stellung des Verbs oft erst am Ende des Satzes die Aussage erkennen lässt. Bei längeren Sätzen muss daher die Frage häufig wiederholt gelesen werden. Auch daraus dürfte sich eine Verzerrung zwischen den einzelnen Sprachen und damit im Vergleich zwischen den einzelnen Ländern ergeben.

Auch die unterschiedliche Motivation der Schülerinnen und Schüler schlägt sich im internationalen Bildungsvergleich der PISA-Studie nieder. Bildquelle: Pixabay

In Bezug auf den Vergleich zwischen den einzelnen Ländern verweist Sjoberg auch auf die unterschiedliche Bedeutung, die den PISA-Tests in den jeweiligen Ländern beigemessen wird. Während in Ländern wie Taiwan oder Singapur anlässlich des Tests die Nationalhymne gespielt und die Schüler patriotisch angespornt werden, haben die Tests für die Schüler anderer Länder oft keinen besonderen Stellenwert. (Vgl. Gegenwind für PISA, S. 368)

Hans Brügelmann, Professor für Erziehungswissenschaft, kritisiert in seinem 2015 erschienen Buch „Vermessene Schulen - standardisierte Schüler - Zu Risiken und Nebenwirkungen von PISA, Hattie, VerA & Co.“, dass die Evaluationsspezialisten aus der Zunft der pädagogischen Psychologie zu einer Differenzierung der Aufgaben, Rollenmuster und Urteilsformen geführt habe. Es sei eine „Expertokratie“ entstanden, welche die Praxis zunehmend entmündigt habe. Dabei gehe es bei der Organisation von Evaluation immer auch um Macht, also darum wer die Ziele und Werte der Evaluation bestimmt und welche Deutungen der Ergebnisse zugelassen werden. Damit werde auf den grundsätzlichen Gegensatz zwischen dem „Vertrauen auf Spezialisten“ und der „demokratischen Kontrolle von Ungewissheit“ hingewiesen. (S. 13)

Misst PISA, was es vorgibt zu messen?

In den Kapiteln „Erfassen die PISA-Tests die Fachleistungen in angemessener Form?“ (vgl. S. 81 – 83) und „Sind die Auswertungs- und Darstellungsformen der erhobenen Daten aussagekräftig und verständlich?“ (vgl. S. 83 – 85) merkt Brügelmann an, dass die Verwendung standardisierter Test, die fachliche Kompetenz durch die Vertrautheit der Schüler im Umgang mit diesen Tests überlagere. D.h. Schüler die mit dem Format von Standardtests vertraut sind, schneiden bei gleicher Fachkompetenz besser ab als Schüler denen das Format fremd ist.

Er zeigt außerdem auf, dass in den Schwerpunktbereichen Mathematik und Naturwissenschaften einerseits und im Lesen andererseits eine hohe Korrelation zwischen den Lösungshäufigkeiten bestehe. Diese lasse erkennen, dass keine ausreichende Trennschärfe zwischen den verschiedenen Bereichen gegeben sei. Lesen sei für alle getesteten Bereiche grundlegend. Außerdem habe sich gezeigt, dass unterschiedliche Testverfahren zu unterschiedlichen Ergebnissen führen würden. So haben z.B. die USA bei den unterschiedlichsten internationalen Vergleichen zur Leseleistung in den vergangenen fünfzehn Jahren vorderste, mittlere bis hinterste Plätze belegt. (Vgl. dazu S. 82)

Auch für Deutschland ergibt sich Angesicht verschiedener internationaler Lesestudien zwischen 1982 – 1998 ein überaus verwirrendes Bild, variiert doch die Anzahl der „Risikogruppe“ beim Lesen von 2 % - 25 %. Es sei daher wichtig, in der öffentlichen Diskussion darauf aufmerksam zu machen, dass sich mit Leistungstests alla PISA & Co. die Qualität des Unterrichts oder der Lernstand einzelner Schüler nicht erfassen lasse.

Trotz der methodischen Sorgfalt der an PISA beteiligten Forscherinnen und Forscher bleiben zahlreiche Fehlerquellen unkontrolliert (vgl. S. 84), über welche die vermeintliche Präzision der Ranglisten hinwegtäuschen würden. Dabei sollten nicht nur die Unterschiede zwischen den verschiedenen Bildungssystemen der an PISA beteiligten Länder vorsichtig diskutiert werden, sondern auch die Zahlen selbst, deren Darstellung und Übersetzung in Schaubilder und Texte immer auch Interpretation seien.

Positiv an methodisch kontrollierten Untersuchungen wie PISA bewertet Brügelmann, dass sie helfen, die Gefahr zufälliger Eindrücke zu verringern. Gleichzeitig werde mit der Anzahl der Teilnehmer die Studie aber auch anfälliger für logistische Probleme bis hin zu Verzerrungen. Aus ökonomischen Gründen lassen sich mit größerer Teilnehmerzahl immer weniger Aspekte genau erfassen. Die Erhebung müssen stärker fokussiert und formalisiert werden, wodurch bei der Wahrnehmung von Sachverhalten und ihrer Deutung der subjektive Faktor zurückgedrängt wird.

Von der Input-Steuerung zur Output-Steuerung

Als positiven Effekt betrachtet Brügelmann, dass die PISA-Vergleichsstudie medienwirksam auf bereits bekannte Probleme und Benachteiligungen im Bildungswesen hingewiesen habe, wie z.B. auf den hohen Anteil der sogenannten „Risikogruppe“, die in engem Zusammenhang mit der sozialen Herkunft oder einem Migrationshintergrund stehe. Auf der anderen Seite sei PISA „zum Symbol für den Paradigmenwechsel in der Evaluierung von Schule und Unterricht geworden“. (vgl. S. 78) Gerade der Wechsel von der Input-Steuerung, die über die Lehrpläne, Qualitätsanforderungen an Lehrende und über Prozesskontrolle durch die Schulaufsicht erfolgt ist, hin zur Output-Steuerung, bei der Leistungen, die sich messen lassen, zum Maßstab für die Qualität von Schule und Unterricht gemacht werden, zeige sich, wie sehr die Kontrolle über die Organisation von Evaluation immer auch Macht bedeute.

Ein wesentlicher Effekt der internationalen Bildungsstudie PISA war, dass sich in den Bildungssystemen der teilnehmenden Länder der Schwerpunkt der schulischen Steuerung von intput- hin zu output-orientierte Maßnahmen verschoben hat. Bild: Pixabay

Das schlechte Abschneiden zu Beginn der PISA-Studie hätten die input-orientierten Maßnahmen der schulischen Steuerungen in Ländern wie Deutschland und Österreich in Misskredit gebracht. Das Input-System wurde für die schlechten Schülerleistungen im internationalen Vergleich verantwortlich gemacht. Die Forderung nach Hinwendung zu einer Output-Steuerung, wie sie in den Ländern der vorderen PISA-Ranking-Plätze vorherrsche, sei immer lauter geworden. Eine genauere Betrachtung ergebe jedoch, dass die Leistungsfähigkeit eines Bildungssystems nur in einem sehr begrenzten Zusammenhang mit dem Steuerungssystem stehe.

Der ehemalige Direktor des Bundesinstituts BIFIE, das mit der Durchführung des PISA-Studie in Österreich betraut wurde, erklärte in der Einleitung des technischen Berichts zur PISA-Studie 2006 mit der Überschrift: „Auf dem Weg zur „Output“-Steuerung“:

Lange Zeit glaubte man in Österreich, auf umfassende und systematische Evaluationen der Ergebnisse des Bildungswesens (den „Output“) verzichten zu können. Die Bildungspolitik legte durchwegs – im falschen Bewusstsein, alles über „System-Engineering per Erlass“ regeln zu können – keinen großen Wert auf die Kontrollpflicht bezüglich der tatsächlichen Ergebnisse.

Ich denke, die Erfahrungen und Entwicklungen der letzten 10 Jahre mit TIMSS und PISA zeigen inzwischen deutlich, dass – neben der Forcierung der Qualitätsentwicklung in den Schulen selbst – eine regelmäßige externe Qualitätsevaluation des gesamten Systems unbedingt notwendig ist. Der Entscheidung über den Erfolg des Systems, der Bestimmung seiner Stärken und Schwächen und der Entscheidung über die notwendigen Maßnahmen sollten umfangreiche, periodisch erhobene Daten über die tatsächlichen Bildungserfolge der Schüler/innen zu Grunde gelegt werden.PISA erfüllt hier (gemeinsam mit PIRLS und TIMSS) die wichtige Funktion der internationalen Anbindung österreichischer Qualitätsindikatoren und des Benchmarkings. Genauso wichtig wird jedoch künftig die umfassende Prüfung von Bildungsstandards an den Schnittstellen des Systems – Bildungsstandards, die an den nationalen Zielen und an gültigen Kompetenzmodellen ausgerichtet sind. Gemeinsam mit den jährlichen schulstatistischen Daten sollen die Ergebnisse von PISA & Co. und die Resultate der Bildungsstandard-Tests in einen Nationalen Bildungsbericht einfließen und die Leistungen und Entwicklungen im Schulsystem verlässlich abbilden – als Basis für bildungspolitische Entscheidungen. Ansonsten besteht die Gefahr, dass die Wünsche und Absichten der jeweils Verantwortlichen bereits automatisch für Realität gehalten werden.

Günther Haider, PISA-Schulsysteme im internationalen Vergleich. S. 16, in: PISA 2006 – Internationaler Vergleich von Schülerleistungen. Technischer Bericht (Stand: 19.01.2018)

PISA zu bewerten sei, so Hans Brügelmann, nicht einfach, da es zahlreiche Faktoren und Fragen zu berücksichtigen gelte. Wer oder was ist PISA? Wer rezipiert die Studie? Dabei dürfe nicht vergessen werden, dass Testprogramme, abhängig vom gesellschaftlichen und politischen Kontext die unterschiedlichsten Nebenwirkungen entfalten könnten. Problematisch sei, dass PISA einmal als Forschungsprogramm und ein anderes Mal wieder als Evaluationsstudie präsentiert werde, ohne zu berücksichtigen, dass für beide jeweils unterschiedliche Anforderungen zu gelten hätten.

Während PISA selbst nur den begrenzten Anspruch habe, einen kleinen Ausschnitt der Wirkungen von Schule zu zeigen, der zwischen verschiedenen Ländern verglichen wird, erhebt die Schulpolitik in manchen Ländern PISA zu einem Programm des „System-Monitoring bis hin zur Schul- und Unterrichtsevaluation“ (S. 79), das den Leistungsstand einzelner Schülerinnen und Schüler bewerten könne. Damit sei die „Standardisierung für viele zum generellen Paradigma der Evaluation von Unterricht und individuellen Lernprozessen geworden. Wenn von PISA & Co. gesprochen wird, ist diese Modellwirkung gemeint.“ (S. 79)

Zusammenfassend bemerkt Brügelmann, dass die durch PISA ausgelöste öffentliche Diskussion den Fokus zu stark auf den Unterricht oder auf das Bildungssystem als Ursache für Probleme bei schulischen Leistungen gerichtet habe. Dabei sei zu rasch von der wichtigen Rolle der Wirtschafts- und Sozialpolitik abgelenkt worden, die für junge Menschen in einer Gesellschaft die wesentlichen Rahmenbedingungen beim Aufwachsen und Lernen festlegen würde. „PISA & Co. können unser Evaluationsrepertoire nur bereichern, wenn wir das Instrumentarium nicht überfordern.“ (S. 94)

Joachim Wuttke geht in seiner detaillierten und interessanten Untersuchung „Die Insignifikanz signifikanter Unterschiede: der Genauigkeitsanspruch von PISA ist illusorisch“ nicht der Frage nach, ob die von PISA veröffentlichten Aussagen richtig oder falsch seien, sondern ob sie sich aus dem bekannten Datenmaterial ableiten lassen würden. Es soll den Unsicherheiten nachgegangen werden, die den erhobenen Daten anhaften, vor allem aber, ob sich der enorme Aufwand für PISA angesichts der festgestellten Unsicherheiten rechtfertigen lasse. (vgl. S. 9)

Als Ergebnis der Untersuchung weist Wuttke daraufhin, dass die Testgebiete von PISA, also die Lese-, Mathematik-, Naturwissenschafts- und Problemlöseaufgaben ineinander übergehen würden, weshalb die Kompetenzwerte der vier Testgebiete eine hohe Korrelation aufweisen. Dies hänge damit zusammen, dass der PISA-Studie das „literacy-Konzept“ und ein utilitaristischer Bildungsbegriff der OECD zugrunde lägen. Kein Bereich lasse sich ohne Lesekompetenz bewältigen. Somit kann man, in der Sprache der multivariaten Statistik, das Antwortverhalten der Probanden zu einem erheblichen Teil durch einen Generalfaktor „erklären“. (S. 91)

Zu den zentralen Fragen an die Bildungsstudie gehört, ob sie auch das misst, was sie vorgibt zu messen? Bildquelle: Pixabay

Dabei messe PISA aber nicht nur kognitive Fähigkeiten und fachspezifische Kompetenzen, wobei die PISA-Berichte den Begriff „Intelligenz“ bewusst vermeiden würden (vgl. S. 91), sondern auch die Vertrautheit mit dem Aufgabenformat, landestypischen Gegebenheiten, den Umgang mit der Testsprache sowie Durchhaltevermögen, Zeitmanagement und Teststrategie. Offiziell hingegen werde der Eindruck erweckt als würde pro Testgebiet nur auf einen Faktor geschlossen, der die Kompetenz im jeweiligen Testgebiet angebe.

Auch in Bezug auf die Genauigkeit der Messergebnisse sind, anhand zahlreicher Fehler und Ungereimtheiten der vergangenen Jahre, die in verschiedenen Ländern wie z.B. auch in Österreich aufgetreten sind, erhebliche Zweifel aufgekommen. Dabei würden sich nur wenige der Verzerrungen wirklich quantifizieren lassen. Etliche nationale Mittelwerte dürften um fünf bis zehn Punkte oder mehr verzerrt sein. (vgl. S. 92 – 95)

Auch wenn die meisten Verzerrungen unsicher bleiben, lassen sich manche Faktoren doch mit ziemlicher Bestimmtheit ausmachen. So überschätze PISA z.B. englischsprachige Staaten, während gleichzeitig die Fähigkeiten der Testteilnehmer unterschätzt würden.

Wer die prozentualen Lösungshäufigkeiten einzelner PISA-Aufgaben wörtlich nimmt, ohne den gesamten Testablauf, das ungewohnte Aufgabenformat, den Zeitdruck und das fehlende Eigeninteresse mitzudenken, unterschätzt die tatsächlichen Fähigkeiten der Schüler und muss erheblichen Bevölkerungsteilen funktionalen Analphabetismus unterstellen.

Joachim Wuttke, Die Insignifikanz signifikanter Unterschiede: der Genauigkeitsanspruch von PISA ist illusorisch“(S. 98)

Weit plakativer zeigt sich die Kritik in der Auseinandersetzung um die Bedeutung und den Einfluss von Bildungsstudien wie PISA mitunter in den öffentlichen Medien. So kritisiert der Bildungsforscher Volker Ladenthin im Beitrag „PISA gefährdet unser Bildungssystem“, PISA habe

„[…] eigenmächtig fremde, nicht vorab demokratisch verabredete Kriterien für das, was gute Bildung sein soll, eingeführt. Die gesetzten Kriterien haben sich dabei keiner breiten und wissenschaftlichen Diskussion über das, was Schule überhaupt soll und will, versichert. Ohne Auseinandersetzung mit dem Stand der Wissenschaft, mit bestehenden Schul- und Bildungstheorien, und auch nicht gemeinsam mit Lehrer- oder Elternverbänden werden die Kriterien der OECD, die übrigens niemand hierzu legitimiert hat, dies zu tun, nun einfach als Maßstäbe gesetzt. So etwas war bisher in der Wissenschaft unüblich.“

Volker Ladenthin: PISA gefährdet unser Bildungssystem

Kritische Stimmen zur OECD als Studienbetreiber

Stefan C. Wolter, der Leiter der Schweizerischen Koordinationsstelle für Bildungsforschung (SKBF) bezeichnete im Dezember 2016 die letzte PISA-Studie als „wertlos“ und sein Vertrauen in die OECD als „erschüttert“. Als Grund nannte er die zunehmende Intransparenz der PISA-Studie sowie deren mangelnde Kritikfähigkeit. Dazu nannte er ein praktisches Beispiel:

Vor kurzem hat die OECD Bildungspolitiker und Wissenschafter aus der ganzen Welt nach Shanghai eingeladen, damit wir das vorbildliche Bildungssystem der chinesischen Millionenstadt kennen lernen können. In der neuen Pisa-Studie aber sind deren Schüler regelrecht abgestürzt. So ist es schwierig, der OECD weiterhin zu vertrauen.

Dennis Bühler, Schweizer Bildungsforscher hält Pisa-Studie für wertlos: "Die Autoren sind wie renitente Schüler". In: Aargauer Zeitung vom 6.12.2016 (eingesehen am 18.01.2018)

Thomas Jahnke, Professor für Didaktik der Mathematik, verweist in seinem Beitrag „Die PISA-Unternehmer – Eine Kritik“ vor allem auch auf die politischen und wirtschaftlichen Interessen im Zusammenhang mit den PISA-Studien.

Dagegen bleibt zunächst festzuhalten: Der mediale Erfolg erhöht die Wissenschaftlichkeit oder die wissenschaftliche Aussagekraft einer Studie nicht. Die Pisa-Studien wurden und werden nicht aus wissenschaftlichen, sondern aus politischen und ökonomischen Interessen durchgeführt auf Veranlassung der OECD; die Auftraggeber erwarten „empirisch fundiertes Steuerungswissen“. Auftragnehmer ist ein Konsortium, das aus fünf sogenannten Educational-Assessment Firmen (vier davon sind private Wirtschaftsunternehmen) besteht, denen es gelungen ist, Pisa mittlerweile an 57 Staaten zu verkaufen.

(Forschung und Lehrer 1/08, S. 26)

Dr. Andreas Schleicher ist ein deutscher Statistiker und Bildungsforscher. Als OECD Direktor des Direktorats für Bildung ist er für die internationale Koordination des Programms for International Student Assessment - PISA-Studie verantwortlich. Bildquelle: Wikimedia: re:publica 2016

Dass mit PISA auch gezielt inhaltliche Veränderungen im Bildungssystem anvisiert werden, zeigt ein Spiegel-Interview mit dem Direktor des Direktorats für Bildung der OECD und Chefkoordinator der Pisa-Studien, Andreas Schleicher:

Schleicher: […] Das ist eine gute Ausgangslage, die digitalen Kompetenzen stärker in den Unterricht einzubringen. Aber es geht nicht nur um Technikwissen, das können junge Menschen meist gut. Wir brauchen kein neues Schulfach. Vielmehr müssen sich alle Fächer stärker daran ausrichten, was Kompetenz im digitalen Zeitalter wirklich bedeutet. Man muss sich heute überlegen: Wo werden Menschen Computer ergänzen, was wird die Menschen befähigen, aus der Nutzung digitaler Technologien Potenzial zu ziehen.

SPIEGEL ONLINE: Haben Sie ein Beispiel?

Schleicher: Ja, die Lesekompetenz. Früher wurde das Verständnis linearer Texte geprüft: Wenn Sie irgendwo eine Antwort nicht wussten, konnten Sie im Lexikon nachschlagen und der Antwort auch vertrauen. Heute schlagen Sie bei Google nach und bekommen 80.000 Antworten und niemand sagt Ihnen, was richtig ist. Sie müssen Wissen konstruieren. Wenn wir den Schülern weiterhin das Verarbeiten linearer Texte beibringen, geht das an den Anforderungen vorbei. […]

Schulpolitik nach der Wahl "Nur fast so gut wie ein Smartphone". in: Spiegel Online vom 25.09.2017

Eine kritische Auseinandersetzung über die Rolle der PISA-Studie im internationalen Bildungssystem bietet Peter Mortimer in seinem Beitrag aus dem Jahr 2009 „Alternative Modelle zur Analyse und Darstellung der PISA-Ergebnisse einzelner Länder“. Dabei arbeitet er zehn wichtige Themen heraus, welche die Diskussion rund um die PISA-Studie die vorangegangenen Jahre bewegt haben sowie notwendige Veränderungsvorschläge und Empfehlungen.

Im Jahr 2014 spricht eine beachtliche Gruppe internationaler Bildungsforscher, in einem offenen Brief an Andreas Schleicher, über ihre großen Bedenken in Bezug auf die negativen Folgen der PISA-Rankings.

Die PISA-Ergebnisse werden regelmäßig von Regierungen, Bildungsministern sowie den Herausgebern von Tageszeitungen ängstlich erwartet und werden in zahllosen politischen Dokumenten als unhinterfragbare Autorität zitiert. PISA hat die Bildungspraxis in vielen Ländern inzwischen tiefgreifend beeinflusst. Als Folge der PISA-Tests reformieren Staaten ihre Bildungssysteme in der Hoffnung, ihr Abschneiden im PISA-Ranking zu verbessern. In vielen Ländern führte der mangelnde Fortschritt bei den PISA-Tests dazu, eine „Bildungskatastrophe“ oder einen „PISA-Schock“ auszurufen, gefolgt von Rücktrittsforderungen und weitreichenden Reformen gemäß PISA-Maßstäben.

[…] Das neue PISA-Regime mit seinen kontinuierlichen globalen Testzyklen schadet unseren Kindern und macht unsere Klassenzimmer bildungsärmer durch gehäufte Anwendung von Multiple-Choice-Testbatterien, vorgefertigten (und von Privatfirmen konzipierten) Unterrichtsmodulen, während sich die Autonomie unserer Lehrer weiter verringert. Auf diese Weise hat PISA den ohnehin schon hohen Grad an Stress an unseren Schulen weiter erhöht und gefährdet das Wohlbefinden von Schülern und Lehrern.

Offener Brief an Andreas Schleicher, OECD, Paris

Verwendete Quellen und Links:

- Bank, Volker / Heidecke, Björn: Gegenwind für PISA Ein systematisierender Überblick über kritische Schriften zur internationalen Vergleichsmessung

- Brügelmann Hans, Vermessene Schulen - standardisierte Schüler - Zu Risiken und Nebenwirkungen von PISA, Hattie, VerA & Co, Beltz Verlag, Weinheim 2015

- Wuttke, Joachim: Die Insignifikanz signifikanter Unterschiede: der Genauigkeitsanspruch von PISA ist illusorisch. In: Jahnke, Thomas (Ed.) ; Meyerhöfer, Wolfram(Ed.): PISA & Co : Kritik eines Programms. Hildesheim : Franzbecker, 2007. - ISBN 978-3-88120-464-4, 129 pages.

- Haider Günther : PISA-Schulsysteme im internationalen Vergleich. S. 16, in: PISA 2006 – Internationaler Vergleich von Schülerleistungen. Technischer Bericht (Stand: 19.01.2018)

- Jahnke, Thomas / Meyerhöfe Wolfram: „Pisa & Co. Kritik eines Programms“

- Landenthin Volker: „PISA gefährdet unser Bildungssystem“

- Prenzel, Manfred: „Wie solide ist PISA? oder Ist die Kritik von Joachim Wuttke begründet?“

- Mortimer Peter: „Alternative Modelle zur Analyse und Darstellung der PISA-Ergebnisse einzelner Länder“

- Radtke, Frank-Olaf: Die Erziehungswissenschaft der OECD - Aussichten auf die neue Performanz-Kultur. S. 109 – 136, Institut Futur, Universität Berlin (eingesehen am 19.01.2018)

- Überblick über die veröffentlichten Beiträge im Sammelband „Pisa & Co. Kritik eines Programms“

- Schulpolitik nach der Wahl "Nur fast so gut wie ein Smartphone". Interview mit Andreas Schleicher, deutscher Statistiker, Bildungsforscher und Chefkoordinator der Pisa-Studien, in: Spiegel Online vom 25.09.2017

- Offener Brief an Andreas Schleicher, OECD, Paris

Andreas Markt-Huter, 22-01-2018